*Actualización del 29/05/2024: La Unión Europea ha establecido un nuevo estandar mundial con la aprobación de la AI Act, que entrará en vigor en junio.

*Actualización del 20/06/2024: se ha publicado el reglamento en el Diario Oficial de la Unión Europea, y entrará en vigor el 1 de agosto. A partir de esa fecha será plenamente aplicable 24 meses después, excepto: prohibiciones de prácticas prohibidas (6 meses después), códigos de buenas prácticas (9 meses después), IAs de uso general incluida la gobernanza (12 meses después) y obligaciones para sistemas de alto riesgo (36 meses).

Se ha hablado y publicado mucho en las últimas semanas sobre la aprobación de la nueva Ley Europea de Inteligencia Artificial (conocida como ‘UE IA Act’), especialmente sobre el hecho de que Europa será pionera en controlar la aplicación de la IA o cómo pondrá coto al poder de las grandes empresas tecnológicas, especialmente a las estadounidenses; sin embargo, apenas se ha profundizado en qué es lo que regula y cómo lo hará, pero sí es cierto que constituye la primera normativa relacionada con la IA de un regulador importante en cualquier lugar del mundo.

La Ley Europea de IA es un Reglamento, ¿qué quiere decir esto?

En primer lugar, se debe aclarar que en realidad más que una Ley sobre la Inteligencia Artificial en sí misma, que sería un concepto tremendamente difuso, es una regulación de los usos de la IA en el entorno de la UE articulada a través de un Reglamento.

La segunda cuestión obviamente es qué es un Reglamento. En la Unión Europea, se legisla por medio de distintos tipos de actos, esencialmente cinco:

- Reglamentos.

- Directivas.

- Decisiones.

- Recomendaciones.

- Dictámenes.

Algunos son vinculantes y otros no, algunos se aplican a todos los países de la UE y otros solo a algunos.

Un Reglamento es de aplicación general a categorías abstractas de personas (no personas identificadas), es obligatorio en todos sus elementos y se aplica directamente tras su entrada en vigor en los Estados miembros, sin tener que ser transpuesto al Derecho nacional.

La tercera cuestión sería qué implica esto para las empresas y ciudadanos de cada país, porque quizá la palabra Reglamento no tiene un significado suficientemente expreso (de ahí que se suelan denominar ‘Act’ o Ley), pero un Reglamento es el acto legislativo más importante en la UE, pues es de cumplimiento obligatorio, vinculante y de aplicación directa, no necesita ser ‘adaptado’ a la legislación de cada país.

Y es que en la legislación europea no existe puramente el concepto ni la palabra ‘Ley’ como en España o la mayoría de los países miembros, pero en la práctica un Reglamento es equivalente a una Ley que atribuye derechos y obligaciones a los particulares y empresas, quienes pueden invocarlo directamente ante los tribunales nacionales, y que pueden utilizarlos como referencia en sus relaciones mutuas, con los Estados miembros o con las autoridades de la UE.

Es decir, nos afecta a todos los particulares y empresas, en toda la UE y no puede existir ninguna normativa de rango nacional, autonómica o local por encima ni que contravenga el Reglamento.

Hay tres aspectos fundamentales sobre cómo nos afecta: los plazos, a qué tipo de servicios y a quienes.

1.- Los plazos

Sobre los plazos, debe resaltarse que aunque ha sido aprobada en un momento en el que la IA está en un punto de máximo interés, no ha sido consecuencia de ella, y estrictamente no está en vigor aún.

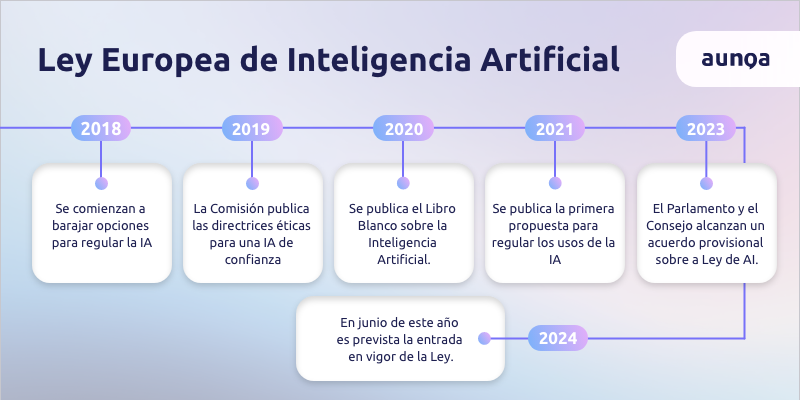

Antecedentes

La Unión Europea comenzó a barajar opciones para regular la Inteligencia Artificial a finales del año 2018, cuando presentó por primera vez una estrategia de IA y acordó un plan coordinado con los Estados miembros. Un año después, la Comisión Europea estableció entre sus prioridades para 2019-2024 conseguir una Europa preparada para el mundo digital, donde se incluía el debate sobre una inteligencia artificial humana y ética. En 2019, la Comisión publicó las Directrices éticas para una Inteligencia Artificial de confianza y en 2020 vio la luz el Libro Blanco sobre Inteligencia Artificial, una estrategia industrial de la IA para que Europa adopte y lidere el desarrollo de esta tecnología, a la vez que propone un marco legislativo que impulse la confianza en la IA respetando los derechos fundamentales y la ética de Europa.

Cronología de la Ley

El inicio efectivo de la Ley llega en 2021, cuando se publica la primera propuesta para regular los usos de la IA con el fin de abordar adecuadamente los beneficios y riesgos de su uso. En concreto se trata de la COM/2021/206, del 21 de Abril de 2021 y cuyo objetivo es ‘introducir un marco normativo y jurídico único para los sistemas de inteligencia artificial que operen en la UE’.

Tras pasar por las distintas Consultas Públicas y Comisiones (muchas) del Parlamento con sus correspondientes (miles) de enmiendas de los grupos parlamentarios, en Diciembre de 2022, el Consejo de la UE adoptó su posición común («orientación general») sobre la Ley de AI.

Entre Junio y Diciembre de 2023, el Parlamento y el Consejo alcanzan un acuerdo provisional sobre la Ley de AI y adopta su posición tras su aprobación a nivel político y técnico por los Estados miembros. Y finalmente, el 13 de Abril de 2024 la Ley fue aprobada en el Parlamento por amplia mayoría.

No obstante, no está todavía en vigor, pues aún está sujeta a una última comprobación jurídica-lingüística y su aprobación definitiva mediante el llamado procedimiento de corrección de errores, y pendiente de su adopción formal por el Consejo, está prevista para antes del final de la legislatura en Junio de 2024.

Efectividad de la Ley

La Ley de IA entrará en vigor 20 días después de su publicación en el Diario Oficial y será de plena aplicación 24 meses después de su entrada en vigor (previsiblemente en torno a verano de 2026), pero con ciertas excepciones, que se adelantan o se atrasan, en concreto las siguientes son las más relevantes:

- La prohibición de las prácticas consideradas inaceptables que se aplicarán 6 meses después de la fecha de entrada en vigor

- Los códigos de buenas prácticas que se implantarán 9 meses después

- Las normas sobre la IA de uso general (GPAI), incluida la gobernanza que se aplicarán 12 meses después

- Las obligaciones para los sistemas de alto riesgo, que se aplicarán 36 meses después (mediados de 2027)

La supervisión

Las normas generales sobre IA estarán bajo la supervisión de las autoridades nacionales, apoyadas por una oficina de IA de nueva creación dentro de la Comisión Europea, y corresponderá a los Estados miembros crear agencias nacionales de supervisión.

En principio, los países tienen 12 meses para nombrar a estos organismos de vigilancia; en España con toda seguridad será la AESIA (Agencia Española de Supervisión de la Inteligencia Artificial), que tendrá su sede en A Coruña y dependerá del Ministerio para la Transformación Digital y de la Función Pública, por medio de la Secretaría de Estado de Digitalización e Inteligencia Artificial. No obstante, la AESIA, si bien ha sido anunciada, no se constituido aun formalmente, encontrándose actualmente en proceso de contratación de personal

2.- Qué regula

La definición de «sistema de IA» es, literalmente la siguiente, según el Artículo 3 [1] de la Ley:

«Un sistema basado en máquinas diseñado para funcionar con diversos niveles de autonomía y que puede mostrar capacidad de adaptación tras su despliegue y que, para objetivos explícitos o implícitos, infiere, a partir de la entrada que recibe, cómo generar salidas tales como predicciones, contenidos, recomendaciones o decisiones que pueden influir en entornos físicos o virtuales.»

Artículo 3 [1] de la Ley.

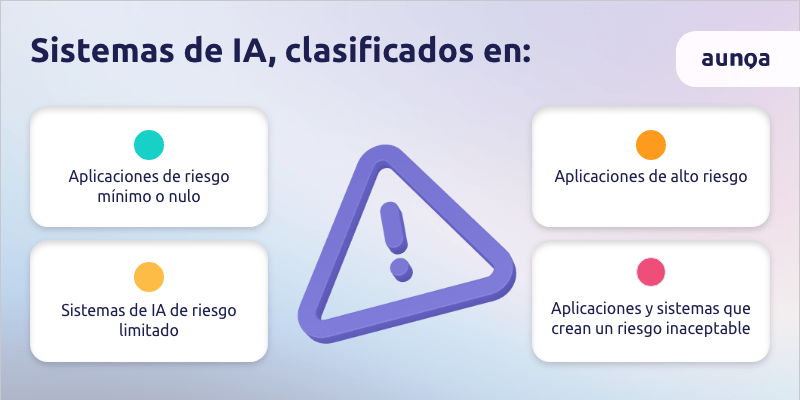

Ya que la definición es muy amplia, el aspecto clave de la Ley es saber a qué sistemas se aplica, ya que contrariamente a lo que su nombre parece indicar, realmente no aplica a cualquier sistema que utilice elementos de IA en su funcionamiento. Lo fundamental de la Ley es que clasifica las aplicaciones de IA en cuatro categorías de riesgo:

- En primer lugar, las aplicaciones y sistemas que crean un riesgo inaceptable, que quedan directamente prohibidos; ejemplos de ellos son los sistemas de puntuación social, de reconocimiento biométrico en espacios públicos, de manipulación emocional, de prevención de delitos mediante perfilado, etc.

- En segundo lugar, se encuentran las aplicaciones de alto riesgo, que estarán sujetas a requisitos legales estrictos y específicos; ejemplos de ello son la gestión de infraestructuras críticas, decisión de acceso a formación educativa o profesional, administración de justicia y procesos democráticos, etc.

- En tercer lugar están los sistemas de IA de riesgo limitado, sujetos únicamente a obligaciones de transparencia, dirigidas a garantizar que los usuarios finales sean conscientes de que están interactuando con un sistema de IA o con contenido generado por IA; fundamentalmente estas obligaciones van dirigidas a evitar la desinformación o los llamados ‘deepfakes’, y también aplicarían a ciertos tipos de chatbots o asistentes virtuales.

- Por último, están las aplicaciones de riesgo mínimo o nulo, en las que se engloban todas las que no están explícitamente prohibidas o catalogadas como de alto riesgo y que no requieren obligaciones de transparencia, y que quedan libres de regulación.

Sin estar encuadrados específicamente en ninguno de los casos anteriores, existe un apartado específico para los modelos de IA de propósito general (GPAI), como los LLM’s, que deben proporcionar documentación técnica, instrucciones de uso, cumplir la Directiva sobre derechos de autor o propiedad intelectual y publicar un resumen sobre los contenidos utilizados el entrenamiento de los modelos.

Con toda probabilidad, la vertiginosa evolución tecnológica de este tipo de modelos ha hecho que sea imposible encuadrarlos en una categoría específica de riesgo, pues es imposible predecir cuáles serán sus capacidades futuras y sus casos de uso; por ello el regulador ha optado por definirlos como un riesgo ‘sistémico’, que en la práctica equivale a decir que en este momento no es posible la identificación, evaluación y medición de sus riesgos, pero que pueden ser potencialmente muy elevados y por tanto deben ser evaluados periódicamente.

Como resumen de este punto debe destacarse que la mayor parte del texto aborda los sistemas prohibidos y los sistemas de IA de alto riesgo, que están estrictamente regulados, y sólo una pequeña parte se ocupa de los sistemas de IA de riesgo limitado, sujetos simplemente a obligaciones de transparencia y que el riesgo mínimo no está regulado, lo que en palabras del propio regulador incluye la mayoría de las aplicaciones de IA actualmente usadas en la UE.

3.- A quien afecta

En este punto son importantes las definiciones, pues pueden inducir a confusión; la definición de usuario en la Ley no corresponde a los usuarios finales del sistema, sino que se refiere a las personas físicas o jurídicas que despliegan un sistema de IA a título profesional (también se refiere a ellos como implantadores), que sería el rol de las todas las empresas que implementen sistemas de IA que interactúen con sus clientes. Pero igualmente, estas obligaciones están ligadas al nivel de riesgo y en este sentido sólo los usuarios (empresas implantadoras) de sistemas de IA de alto riesgo tienen obligaciones relevantes.

Por otra parte están los proveedores o desarrolladores, en los que recaen la mayoría de las obligaciones, que sería el de las empresas que crean software que utilizan la IA de una forma u otra con el objetivo de comercializarlas para que las utilicen usuarios finales (ciudadanos) u otras empresas (los implantadores anteriormente comentados). De nuevo, solo existen obligaciones relevantes para aquellos que desarrollen sistemas de IA de alto riesgo que pretendan comercializar o poner en servicio en la UE, independientemente de que tengan su sede en la UE o en un tercer país. En este aspecto, las obligaciones de las empresas que no desarrollen sistemas de alto riesgo se circunscriben a las relativas a facilitar la transparencia en el sistema, según se recoge en el artículo 50.1:

«Los proveedores garantizarán que los sistemas de IA destinados a interactuar directamente con personas físicas se diseñen y desarrollen de forma que las personas físicas afectadas sean informadas de que están interactuando con un sistema de IA, a menos que ello resulte obvio desde el punto de vista de una persona física razonablemente bien informada, observadora y perspicaz, teniendo en cuenta las circunstancias y el contexto de uso.»

Artículo 50.1

De forma general, la mayoría de los casos de uso en donde actualmente se emplean sistemas de IA en las empresas no están sujetos a regulación, ya que no suponen un riesgo significativo de daño para la salud, la seguridad o los derechos fundamentales de las personas físicas, incluido el hecho de no influir materialmente en el resultado de la toma de decisiones, según se recoge en el Artículo 6.2a si se cumplen uno o varios de los siguientes criterios:

«(a) el sistema de IA está destinado a realizar una tarea de procedimiento limitada;

(b) el sistema de IA está destinado a mejorar el resultado de una actividad humana previamente realizada;

(c) el sistema de IA está destinado a detectar patrones de toma de decisiones o desviaciones de patrones de toma de decisiones anteriores y no está destinado a sustituir o influir en la evaluación humana previamente completada, sin la debida revisión humana; o bien

(d) el sistema de IA está destinado a realizar una tarea preparatoria de una evaluación pertinente a efectos de los casos de uso enumerados en el anexo donde se recogen las actividades de alto riesgo .»

Artículo 6.2a

4.- Conclusiones

Para finalizar, es necesario aclarar dos aspectos que han generado bastantes dudas en torno a la aplicación de esta Ley de la IA:

- El manejo de los datos: la ley de IA no entra para nada en qué tipo de datos se tratan en los sistemas ni en cómo se deben manejar. No es su objeto, para eso está el GDPR (otro Reglamento, de 2018) y todo lo relativo al tratamiento se debe seguir rigiendo por éste, nada cambia.

- Las automatizaciones totales o parciales en muchos trabajos hasta ahora desarrollados por humanos que pueden producirse por la aplicación de los sistemas de IA, y que son objeto de múltiples debates, no son susceptibles de regulación ni de aplicación de la Ley de IA; se trata de una mera evolución tecnológica como en su día lo fueron los ordenadores personales o Internet. Lo que regula la Ley es la posibilidad de que estos sistemas tomen decisiones que influyan en la vida de las personas y si es así, prevenir que dichas decisiones tengan sesgos de cualquier tipo, o bien que se utilicen para cometer o apoyar actividades ilícitas o ilegitimas.

En conclusión, los casos de uso actuales más frecuentes de la IA, como automación de procesos, extracción y sumarización de información o atención al cliente no plantean riesgo desde el punto de vista de la regulación prevista con la entrada en vigor de la UE IA Act, excluyéndose por completo su calificación de sistemas inaceptables o de alto riesgo en los que se centra el grueso de la Regulación.

No obstante, conviene ir revisando la evolución del Reglamento de cara a incorporar en el futuro las medidas concretas referidas a la transparencia y las recomendaciones que se recojan en los códigos de buenas prácticas.